Les enjeux du stockage collaboratif, tour d'horizon des solutions en 2020

DAS, NAS, stockage de production réseau. Quel stockage pour quel usage ?

Le stockage est un vaste sujet, mais il est un composant indispensable de toute configuration, qu'elle soit autonome, indépendante ou membre d'un réseau de machines. La diversité des solutions et des utilisations nous amène à faire un point aussi détaillé que possible sur les différentes technologies de stockage disponibles à ce jour aussi bien pour un usage individuel que pour un usage collaboratif.

Nous distinguerons ainsi 3 grandes catégories de stockage :

- Le DAS (direct attached storage) ou stockage en attachement direct.

- Le NAS (network area storage) "grand public" ou démocratisé.

- Le Stockage réseau de production (NAS Professionnel ou SAN)

1/ Les différents types de DAS

On retrouve dans cette catégorie de stockage la plus répandue les modèles suivants :

- Les disques ultra compacts

- Les disques portables

- Les disques de bureau

- Les disques RAID

Les disques ultra compacts

Depuis toujours il existe des unités de stockage de petite taille (clefs usb, cartes flash, etc). Les progrès réalisés dans le domaine du stockage flash et en particulier sur la mémoire NVMe rendent désormais possible l’association de compacité, capacité et performances.

Il existe en effet depuis quelques années des produits comme le Samsung T5 (T7 en 2020) ou les LaCie Portable SSD qui permettent des performances en lecture/ écriture moyenne de 540 Mo/s tout en conservant des dimensions inférieures à la plupart des smartphones.

Ces disques ne sont pas forcément les moins chers au To mais représentent le meilleur outil pour sauvegarder rapidement le contenu de son ordinateur portable et les données du quotidien. Les capacités à ce jour vont jusqu’à 2 To et peuvent désormais être encryptés matériellement pour bénéficier d’une sécurité à toute épreuve en cas de perte ou de vol.

Les connexions USB 3 Gen2 , USB-C et USB Type A leur donnent une grande polyvalence et interopérabilité.

Certains produits comme ceux de LaCie bénéficient à la fois d'une garantie longue durée (5 ans) mais également d'un service de récupération de données en cas de défaillance matérielle. Nous les considérons comme de très bons outils de sauvegarde pour un usage en mobilité.

Les disques portables ou transportables

Nous ferons volontairement l’impasse sur le disque USB 2/3 que l'on trouvé dans le supermarché du coin car ils représentent généralement ce qui se fait de pire sur ce marché. Leur seul attrait est leur prix.

Ces disques majoritairement mécaniques (à plateaux) sont lents, fragiles et généralement la connexion USB est soudée, ce qui rend la récupération de données ardue si celui-ci est cassé ou défectueux. Ce sont des disques considérés comme mobiles mais ils n’en ont que le nom.

LaCie fut un véritable précurseur avec sa (fameuse) gamme Rugged il y a plus de dix ans, reconnaissable par sa enveloppe de protection (bumper) de couleur orange. Ces disques 2,5" avaient à l’époque le gros avantage d’être résistants au chocs et à l’eau ce qui les a rendus extrêmement populaires dans le milieu de la photo, tournage et de la post-production en conditions de mobilité.

Ces produits ont évolué en intégrant soit un RAID matériel, des lecteurs de cartes mémoires intégrés, ou le fin du fin avec du stockage NVMe.

Les constructeurs comme G-Technology sont arrivés sur ce marché mais dix ans plus tard.

Le Rugged qui était initialement un stockage mobile USB 2 solide mais lent est devenu un produit solide et extrêmement rapide avec l’arrivée du Rugged SSD Pro (jusqu’à 2800 Mo/s en lecture) permettant de supporter des workflows très exigeants en bande passante et en mobilité. Il est aussi le parfait cache sur Mac pour DaVinci Resolve ou la suite Adobe Creative Cloud.

D’autres produits un peu différents comme le Rugged RAID Shuttle sont arrivés sur le marché récemment. Ce produit initialement pensé pour le tournage a trouvé d’autres usages. Il permet de bénéficier de 8 To de capacité en RAID 0 et correspond à la taille d’un ordinateur portable 13" ou d’une enveloppe Fedex. Il est rapidement devenu incontournable pour les transferts entre les différentes entités d’une production car il allie une bonne compacité, une performance décente et une robustesse adaptée.

Il en est de même pour le Rugged BOSS SSD qui permet de sauvegarder les rushes directement sur le lieu de tournage sans passer par un ordinateur pour le transfert, tout en gardant la compacité d’un disque portable.

Le niveau de fiabilité extrême ainsi que les garanties étendues associés aux services de récupération de données en font une gamme que nous recommandons tout particulièrement.

D'autres fabricants proposent des produits équivalents ou concurrents, cependant l'expérience n'est pas aussi probante en termes de fiabilité et surtout de service client en cas de panne.

Les disques de bureau

Les caractéristiques principales des disques durs de bureau ont peu changé avec les années. Ce qui va principalement les définir aujourd’hui réside en trois points : la capacité, la connectivité et le design. Un disque de bureau se résume finalement à un disque 3,5" SATA connecté à un contrôleur USB ou Thunderbolt (pour les connexions en série). Ces boitiers sont mono disques et donc par définition limités en termes de capacité, performances mais surtout sécurité.

Le disque à plateaux a beaucoup évolué ces dernières années en terme de technologie. La seule possibilité pour les fabricants pour contrer l’avance inexorable des SSD a été de travailler sur les capacités et le coût au To. Il est désormais possible de se procurer des disques durs jusqu’à 16 To pour un coût "raisonnable". Les performances sont de l’ordre de 230 Mo/s en lecture/écriture, ce qui est tout à fait correct pour les usages communs mais peut vite devenir critique en post-production car les performances s’effondrent sur les accès simultanés et sont insuffisantes pour supporter la plupart des codecs UHD actuels.

On peut envisager d’utiliser ces disques comme copie de sauvegarde ou d’archivage. Dans ce cas, la double copie au minimum devient indispensable car un disque dur qu’il soit flash ou mécanique est par définition extrêmement faillible. La double copie est sans doute la solution en apparence la plus économique pour commencer. Elle est cependant extrêmement contraignante et chronophage.

De plus, elle n’est pas fiable sur le long terme car plus un disque vieillit plus il est susceptible de lâcher et ces produits sont conçus pour fonctionner. Le stockage de disques sur l’étagère (particulièrement si stockés sur la tranche) conduit à un taux de défaillance élevé qui s’accentue année après année.

Utiliser un disque dur "nu" dans un dock de bonne qualité comme ceux que peut proposer OWC ou un disque externe classique dans un boitier n’a aucune différence technique. La différence se fera sur la manière dont ils sont stockés et manipulés. Le disque "nu" est bien sur beaucoup plus susceptible de prendre un choc si manipulé quotidiennement.

A ce jour, LaCie remporte la palme aujourd’hui en ce qui concerne les disques de bureau. La gamme d2 particulièrement se révèle pratique et agréable à l’oeil. Elle bénéficie comme les autres produits de la garantie 5 ans associé au DataRescue et propose des boitiers Thunderbolt 3/USB C polyvalents et robustes. Les disques internes sont de la gamme entreprise ce qui leur garantit une durée de vie relativement plus élevée que les disques de bureau de la concurrence. La gamme d2 Thunderbolt 3 est à privilégier car facilement intégrable dans une chaîne de périphériques contrairement au modèle d2 Professional qui a la couleur des iMac pro mais seulement un port unique USB-C qui ne permet aucune connexion en série.

Les disques RAID

Les principaux types de RAID :

RAID 0 : un minimum de deux disques sont agrégés pour cumuler leurs performances. Ce système est le plus rapide mais comporte un risque de défaillance extrêmement élevé car si un disque lâche toutes les données sont perdues. Ce type de RAID est à proscrire si vos données ne sont pas perpétuellement sauvegardées sur un autre périphérique sécurisé.

RAID 1 : souvent utilisé sur les petits disques ou disques système. Il est constitué de deux disques en miroir. En cas d’échec de l’un des disques, les données seront toujours accessibles sur l’autre. Ce type de matrice RAID n’améliore pas les performances mais sécurise les données. Un boitier RAID de deux disques annoncé à 16 To par exemple aura 8 To de capacité utile en RAID 1, 16 To en RAID 0.

L’expérience prouve que lorsqu’un des deux disques lâche sur un RAID 1, l’autre suivra rapidement, particulièrement si c’est un SSD. Nous recommandons en cas de défaillance d’un des disques de prévoir un remplacement du second disque après changement du premier.

RAID 5 & 6 : un minimum de 3 disques est requis. Ce type de RAID permet de cumuler les performances de chaque disque tout en étant sécurisé puisqu’un disque peut lâcher sans que l’on perde les données. C’est le RAID le plus fréquemment utilisé en post-production.

Cependant, si vos données ne sont pas du tout sauvegardées, nous recommandons le RAID 6 qui lui utilise deux disques pour la parité et propose donc ainsi une meilleure tolérance aux pannes.

Sur la plupart des systèmes RAID 5 & 6 il est possible d’allouer un ou plusieurs disques de "spare" qui prendra le relais automatiquement en cas de défaillance d’un des disques de la matrice RAID. Cela induit de "sacrifier" un ou plusieurs emplacements dans le chassis RAID mais peut s’avérer très utile pour les systèmes très sensibles ou peu surveillés car le contrôleur lance la reconstruction dès qu’un disque lâche sans attendre une intervention manuelle de remplacement de la mécanique défectueuse.

Comme expliqué pour le RAID 1, les disques ont tendance à lâcher en cascade car souvent fabriqués en même temps et totalisant le même nombre d’heures et la même utilisation. On observe souvent ce genre de phénomène sur les systèmes vieillissants. Si vous vous retrouvez à partir de 5 ans d’âge du système à remplacer les disques trop régulièrement, c’est que toute votre grappe de disques est en fin de vie. Sa fiabilité et ses performances ne sont plus au rendez-vous.

Il existe trois grandes familles de disques RAID : Les disques RAID logiciels, les disques RAID matériels avec contrôleurs externes et Les disques RAID matériels avec contrôleurs intégrés.

Les disques RAID logiciels

Ce type de boitiers n’intègre pas de contrôleur RAID interne. Des fabricants comme OWC proposent souvent ce type de solution car plus économique. Elle peut être intéressante pour un cache SSD par exemple qui resterait en permanence sur une machine. Sinon, elle est à proscrire car le logiciel de gestion du RAID doit être installé et activé sur l’ordinateur sur lequel le disque est branché et le risque de perdre la matrice RAID, donc les données est plus élevé.

Les RAID matériels avec contrôleurs externes

Cette technologie est utilisée pour gérer des boitiers SAS le plus souvent ou un ensemble de disques montés en interne dans un PC. C’est une carte PCIe ou un boitier Thunderbolt qui gère un ensemble de disques durs connectés en SAS ou SATA. Cette solution souple et performante est très utilisée sur les NAS de production et les gros systèmes d’étalonnage car elle permet une optimisation fine de la ou des matrices RAID et peut gérer un nombre relativement de disques et de matrices.

Avec l’avènement du thunderbolt, elle a été progressivement remplacée par des boitiers ou le contrôleur est intégré, plus faciles à transporter et à exploiter.

Les disques RAID matériels avec contrôleurs intégrés

Ce type de produit est le plus répandu aujourd’hui en postproduction. Les quatre acteurs principaux de ce marché des produits transportables sont LaCie, G-Technology, Promise et Accusys.

Ce type de baie RAID commence à deux disques configurables en RAID 0 ou RAID 1 pour aller jusqu’à 12 en RAID 5 ou 6. Au delà de 12 disques, il faut passer sur des systèmes rackables qui nécessitent une salle serveur ou un local dédié du fait de leur niveau sonore et leur besoin de refroidissement. Seul Accusys propose des systèmes transportables et chaînables. N’hésitez pas à nous consulter pour en savoir plus.

Ces disques sont conçus pour offrir à la fois performance, capacité et fiabilité. Un système 6 disques offrira environ 980 Mo/s en lecture/écrtiure avec une connexion Thunderbolt 3, le double pour un modèle avec 12 disques.

Même si les solutions LaCie offrent par exemple des performances très élevées et stables en accès séquentiels, ils peuvent vite se retrouver mis en défaut sur des accès aléatoires. Dans ce cas de figure, les produits G-Tech et Promise (qui partagent le même contrôleur RAID) seront meilleurs en accès aléatoires et concurrents mais moins bons en accès séquentiels. Cette différence permet de cibler les usages. Nous recommandons les solutions RAID LaCie en usage de montage et d’étalonnage (hormis les workflows en suite d'images) et les G-Tech/Promise en VFX ou 3D où des accès simultanés sur une grande quantité de petits fichiers sont requis.

Il est possible désormais de se procurer des systèmes full SSD (Shuttle SSD Pro chez G-Tech) ou full NVMe. On dispose là de systèmes compacts et très rapides qui permettent des accès lecture/écriture jusqu'à 2800 Mo/s mais souvent de faible capacité. Le coût au To reste encore élevé face aux systèmes mécaniques.

Il existe aussi de grosses entités de stockage rackables de 16 disques ou plus. On les retrouve parfois sur les très gros systèmes d’étalonnage. Accusys est le fabricant le plus répandu dans ce cas car rapide, fiable mais cependant abordable. Ces systèmes se retrouvent également dans les grosses entités de stockage partagés SAN ou NAS avec des fabricants comme Infortrend ou Accusys. Nous consulter pour des solutions personnalisées.

Les NAS "maison"

Les NAS nommés “maison” commencent souvent par un besoin basique : partager un fichier sur le réseau. C’est à partir de ce constat qu’on va commencer à réfléchir à nos besoins et faire avec les moyens du bord.

Le plus simple est de partager depuis son PC ou son Mac un fichier et laisser les autres y accéder par l’onglet des périphériques réseau. Cet usage peut suffire à la plupart des ménages. Très vite se pose le problème de l’ordinateur qui est redémarré alors qu’il partageait un fichier ou de la gestion des droits (qui a effacé …. ), de la stabilité du service et des performances si on partage des éléments vidéo.

MacOS Server

Si on était sur Mac, la tentation était grande (et légitime) de télécharger feu MacOS server et de se monter un serveur réseau “digne de ce nom”. Cette solution bien qu’ayant fait ses preuves dans différents environnements n’était pas d’une stabilité redoutable et demandait très rapidement des compétences informatiques plus poussées. De plus, pour différentes raisons inhérentes à Apple elle-même, les performances des drivers réseau de ces machines n’ont jamais été réellement optimisés que ce soit en simple lien ou agrégat (ne parlons pas des cartes réseau des PowerMac G5 de l'époque qui tournaient à la moitié de leur vitesse théorique... ou de celles des iMac Pro et Mac mini 2018-20).

A cela, venait s’ajouter le besoin de sécuriser son espace de stockage avec des solutions RAID ou autres. Le partage de fichiers depuis Mac OS pouvait vite devenir coûteux, complexe et malgré tout instable en forte charge. De plus, la gestion des droits et la fragilité du filesystem HFS en font des solutions très fragiles.

Nous connaissons toutefois certaines installations qui tournent relativement bien, y compris avec du matériel récent car les personnes qui les ont mises en place connaissentleurs “caprices” et les surveillent attentivement. Quid du jour où la personne est absente ?

Windows server

Il est aussi très simple de partager des fichiers depuis un client windows mais avec beaucoup de limitations. On va donc vite envisager de passer sous Windows Server qui coûte autrement plus cher et est beaucoup plus complexe (et complet ) que feu Mac OS server par exemple. Dès que l’on va vouloir gérer droits et permissions par exemple on va très vite être tenté de monter un service Active Directory qui va vite devenir une usine à gaz si mal gérée/configurée.

Il va être rapidement possible de monter un service de partage relativement stable et performant mais la mise en production de la solution aura eu un réel coût si faite par un professionnel ou un coût humain si déployée en interne. Les problématiques de gestion des droits et de suivi de la solution sont relativement identiques à ceux évoqués sous Mac OS (Server ou pas).

Cependant à grande échelle, il est évident que Windows Server est très abouti et polymorphe mais répond-il vraiment à ce besoin particulier de simplement et rapidement partager des fichiers ? Rien n'est moins sur.

FreeNAS

Il est extrêmement aisé d’installer la plateforme FreeNAS basée sur FreeBSD, une plateforme Open Source. L’installation se passe bien généralement, c’est relativement documenté et la communauté très généreuse en conseils et recommandations. Cependant, il ne faut pas avoir peur de mettre les mains dans le cambouis et une bonne connaissance d’Unix est pré requise pour ne pas vite perdre la main sur le système.

De plus, le coté Plug & Play de cet OS fait qu’il va tourner sur des drivers génériques et sans optimisation par défaut ce qui peut vite rendre le niveau de performances décevant, surtout si la base matérielle est puissante (processeurs, contrôleurs RAID...).

Les NAS polyvalents

Depuis vingt ans pour le premier et seize pour le second, Synology et QNAP n’ont cessé de proposer et améliorer des solutions de partage réseau. (Pour des raisons de fiabilité et de qualité de support, nous allons utiliser Synology dans nos exemples. Plusieurs expériences malheureuses avec QNAP ne nous ont pas vraiment convaincu.

L’offre actuelle va du simple NAS grand public 2 disques jusqu’à 72 disques voir plus. Ces solutions ont un gros avantage : elles se reposent sur un OS qui va être commun à toute la gamme et relativement simple à utiliser. Cela va permettre d’avoir une quantité relativement large de modules logiciels à ajouter à ce NAS, que ça soit de la virtualisation, du streaming, serveur DHCP, Active Directory et bien d'autres...

Simplement ces services consomment des ressources processeur et notre NAS possède un RAID logiciel dont les performances sont en partie liées justement à la ressource processeur. Votre NAS de stockage doit-il, parce qu’il peut le faire, héberger une machine virtuelle, un accès FTP et un service de transcodage ? C'est plutôt à éviter.

Ces solutions ont cependant un gros défaut : elles reposent sur un OS qui va être commun à toute la gamme et pas forcément optimisé en terme de performances.

Explications : Dans leur cas le RAID est logiciel, le niveau de performances va dépendre de nombreux facteurs comme le type de disques utilisés, le type de processeur, la quantité de mémoire vive du NAS et son nombre d’utilisateurs.

Ces solutions ne sont pas dédiées aux métiers de l’audiovisuel, elles peuvent fonctionner mais nous en détournons en quelque sorte leur usage.

Concrètement, un Synology 12 disques avec des disques SATA 3,5” en RAID 6 plafonnera dans le meilleur des cas (volume vide et un utilisateur en test) à 700 ou 800 Mo/s en lecture/écriture monoflux. Un DAS ou NAS avec un RAID matériel sortira au moins le double.

De plus, les accès simultanés à des ressources vidéo moyennement lourdes vont vite s’effondrer en multi-accès. Concrètement, dans le cas d’une structure ou 3 monteurs utilisent le NAS, les choses vont commencer à compliquer du moment où le 3ème utilisateur va commencer à travailler. La solution n’étant pas optimisée pour ces métiers, elle n'applique pas de priorité vis à vis des flux et le RAID logiciel va vite atteindre ses limites.

Si un opérateur a le malheur d’arriver et commence à décharger ses rushes sur le NAS, donc génère des requêtes en écriture là où les monteurs ont besoin de performances en lecture, plus personne ne pourra travailler correctement. Les disques SATA en ont effet pour principale différence avec les disques SAS de ne pouvoir gérer une lecture /écriture simultanée donc les performances s’effondrent lorsqu’on fait ce genre de requêtes de façon intensive ou continue.

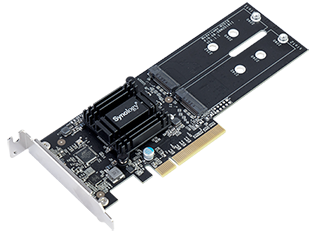

Le Cache SSD

La solution trouvée pour pallier partiellement à ce problème va être d’adjoindre à ce NAS Synology un RAID SSD correspondant si possible à la quantité de données qui va être utilisée pendant la journée de travail.

Les fichiers resteront sur ce RAID SSD pendant la journée et seront copiées sur le RAID HDD quand l’activité baissera ou que le RAID SSD sera plein.

C’est une solution assez courante désormais qui va permettre à notre structure avec trois monteurs de monter sans pertes d’images tant que la quantité de données à copier par le chef opérateur n’excédera pas la taille du cache. A partir du moment ou celui ci aura besoin de se décharger sur le RAID HDD, les performances vont diminuer drastiquement.

Cela reste néanmoins une bonne solution pour permettre à un NAS d’être utilisable en post production car les latences dues au RAID mécanique sont réduites. Le gros défaut à mon avis de cette solution réside en deux points :

Si le RAID SSD tombe en panne on risque de perdre toutes les données présentes dessus (en l’occurence la journée de travail …. ) et la technologie de mise en cache actuelle fonctionne (seulement) en mode fichier. Concrètement, vous avez un projet Resolve avec 24 heures de rushes. Vous montez ce jour 4 minutes extraites de ces 24 heures de Rushes. Si vous utilisez 10 secondes à l’intérieur d’un rush de 40 minutes, l’intégralité du rush va remonter dans le cache SSD. Appliquez cette règle à l’intégralité du projet multipliée par 3 ou 4 monteurs, vous risquez de vous retrouver très vite avec un cache saturé, et donc de perdre tout le bénéfice de cet "artifice" technique.

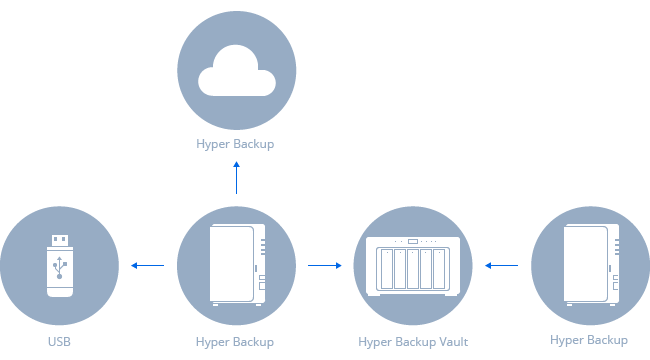

Les services associés et valeur ajoutée

Nous recommanderions à l’heure actuelle d’utiliser ce type de NAS pour des usages de Nearline ou d’archivage en ce qui concerne le stockage. Si votre infrastructure dispose d’un accès à internet via la fibre, ils peuvent aussi être utilisés comme un cloud personnel pour les différentes stations de travail, un serveur VPN, un serveur de partage de fichiers...

Si ce NAS fait partie de la gamme entreprise, il pourra éventuellement gérer (à titre de dépannage) un service d’hébergement de vidéos. Comme toujours, mettre tous ses oeufs ou en l’occurence tous ses services dans le même panier n’est pas recommandé. Des solutions de haute disponibilité (c’est à dire avoir deux NAS identiques pour que l’un prenne le relais en cas de défaillance de l’autre ) existent mais peuvent devenir rapidement coûteuses et compliquées à maintenir.

Dédier un NAS secondaire à une archive locale, serveur VPN et partage de fichiers est le plus courant. Ce NAS étant souvent un réplication du stockage de production, il servira de "Disaster recovery" en cas de défaillance de celui ci. Dans tous les cas, ce NAS étant souvent sur site, il est recommandé de copier ses données à l’extérieur, que ce soit un autre NAS ou un espace cloud en cas d’incident majeur au sein des locaux principaux.

Les serveurs de production (média)

La famille des serveurs de production est très grande à l’image des besoins qui peuvent varier fortement d’une structure à l’autre.

Historiquement, le stockage collaboratif dans la production audiovisuelle était basé sur du stockage SAN. Pour faire court, tous les postes clients avaient un accès physique au stockage au travers d’une liaison Fiber Channel. La gestion de la métadonnée permettant de gérer l’identification et l’accès au fichier passait par un réseau dédié. D’autres fabricants proposaient une connexion iSCSI par un réseau dédié entre le client et le stockage.

Toutes ces solutions avaient l’avantage d’être rapides car on accédait aux fichiers en mode bloc et on contournait ainsi les lenteurs des protocoles de partage réseau qui n’étaient pas encore aboutis ou assez rapides. Cependant, il fallait installer un logiciel sur le poste client qui devait contourner antivirus et firewall et qui demandait souvent une licence dédiée.

Ces infrastructures avaient deux problèmes majeurs : elles coûtaient très cher et pouvaient être très compliquées à maintenir en production. Il n’était pas rare dans les grosses structures d’avoir un technicien dédié à la maintenance du SAN. De plus, il était quasi impossible d’ajouter du stockage sans "casser" tout le SAN et être ainsi hors production pendant quelques jours.

Un autre inconvénient de ces solutions étaient qu’elles nécessitaient souvent que les postes clients soient du même OS, même version du gestionnaire de SAN. Le moindre changement logiciel ou matériel pouvait vite devenir un casse tête.

Pour ces différentes raisons, certains fabricants de stockage se sont intéressés très tôt au stockage de production basé sur les protocoles réseau "génériques". L’avantage est que ces protocoles sont "universels" et sans limitation du nombre de postes connectés autre que la capacité de l’infrastructure réseau à gérer le trafic.

Le Fiber Channel a perduré relativement longtemps car les investissements avaient été conséquents et le matériel durable. De plus, dans beaucoup de sociétés, l’infrastructure technique du réseau n’était pas en capacité de gérer la bande passante nécessaire à un réseau de production.

Les choses ont commencé à bouger il y 4 ou 5 ans quand les commutateurs Ethernet 10Gb ont commencé à devenir abordables. Il était d'autant plus facile si votre câblage réseau était récent afin de garantir 650 Mo/s au minimum entre le poste client et le serveur. C’est plus ou moins équivalent aux performances du Fiber Channel à 8 Gb.

En conséquence, nous avons commencé à équiper nos clients de solutions "hybrides" ou il était encore possible de se connecter aux stockages en Fiber Channel pour les anciennes machines et en 10 Gb Ethernet pour les plus récentes. Cette solution avait un principal inconvénient : il fallait toujours installer un logiciel sur les postes clients pour se connecter au stockage. Ces technologies étant basées historiquement sur la technologie SAN, les problématiques d’augmentation de capacité de stockage ou de bande passante, la gestion des licences serveur et client, bref leurs points faibles restaient les mêmes.

Ces solutions technologiques certes éprouvées et robustes commencent néanmoins à marquer leur âge. La plupart des fabricants restent coincés dans leur approche et leur philosophie alors que le partage par le réseau en utilisant les protocoles génériques peut désormais fonctionner aussi bien voire mieux.

La démocratisation tarifaire des réseaux en 10/25/40/50/100 Gb/s et la généralisation des interfaces et de la commutation a permis de basculer vers des solutions de stockage basées sur le réseau uniquement tout en réutilisant éventuellement les câbles fibre optiques qui avaient été installés pour le Fiber Channel.

C’est à partir de de moment que les fabricants ayant fait le pari du tout IP plutôt que du stockage bloc il y a 10 ans peuvent démontrer aujourd’hui l’étendue de leur savoir faire et leur avance en la matière.

Nous avons choisi de travailler désormais avec GB Labs, un fabricant de stockage anglais qui nous semble répondre au mieux aux problématiques de nos clients. En effet, cette société était historiquement un des plus gros intégrateurs d'infrastructures SAN au Royaume-Uni. Ils se sont vite rendus compte que les solutions SAN étaient parfois surdimensionnées ou inadaptées aux besoins ou fonctionnement de leurs clients.

Les technologies exclusives des produits GB Labs

CORE OS - BLUESHIFT

Ils ont très vite commencé à fabriquer leur propres NAS et ont acquis un grand savoir faire en terme d’optimisation des matériels et protocoles réseau pour arriver à transporter les flux Audio Vidéo aussi rapidement que sur un SAN. Ils ont ainsi depuis dix ans développé une expertise en optimisation des protocoles et des interfaces et commutateurs réseau pour obtenir le moins de latence possible tout en conservant le taux de transfert.

Une fois ce travail d’optimisation effectué, ils ont commencé à développer leur propre Operating System pour leurs serveurs afin de pouvoir optimiser au mieux les tâches internes à celui-ci et mettre en place des outils d’analyse des flux transportés qui vont permettre au serveur de s’adapter dynamiquement en fonction du type de requêtes et du nombre d’utilisateurs.

NETWORK TOOLS

Ils ont réalisé qu’il fallait fournir à leur utilisateurs (et à leur support ) des outils permettant d’identifier les points de défaillance sur un réseau d’entreprise afin d’éviter qu’un câble malencontreusement branché au mauvais endroit par un opérateur non averti ne vienne mettre en péril la stabilité de l'ensemble. Ce qu’ils ont fait.

IDA - VRE - NITRO

La base était là. Ils disposaient de serveurs dédiés et optimisés à nos métiers, de capacité d’optimisation des réseaux sans sur-couche logicielle.

Ils ont ensuite naturellement travaillé sur l’optimisation des contrôleurs RAID de leurs serveurs pour en tirer la quintessence et se sont vide rendus compte que les RAID mécaniques avaient leurs limites.

Très tôt, ils ont travaillé sur une technologie de caching par bloc et non pas par fichier se basant sur les outils d’analyse internes au serveur. Ainsi, lorsque le serveur constate qu’un utilisateur fait appel 7 fois à un bloc de données dans un temps défini, il va le copier sur son cache SSD. Etant donné qu’il ne copie que les blocs utilisés et non pas tout le fichier source, cette copie est transparente et instantanée. Cela va permettre à une multitude d’opérateurs d’accéder aux données utilisées avec une latence quasi nulle. Concrètement, un monteur travaille en moyenne sur trois ou quatre minutes de montage quotidiennement avec peut être 60 minutes de rushes utilisés. Il aura un accès privilégié à ses données, même si il y a 24 heures de rushes dans son projet car uniquement les fragments utilisés seront copiés dans le cache.

En termes de comparaison, le Synology mentionné plus tôt aurait copié sur son cache l’intégralité des rushes ouverts dans le projet soit 24 heures. Ça ne sert à rien, ça prend de la place sur le cache et nuit aux performances globales du sytème.

Cette technologie de caching avancée a permis de mettre en place une autre fonctionnalité à ma connaissance quasi-unique sur ce marché qui est la mise en priorité du type de flux.

PRODUCTION MODE

Toute personne ayant déjà utilisé un stockage collaboratif a constaté qu’il était souvent impossible de garantir une écriture continue (capture vidéo par exemple ) et une lecture simultanée (montage ) stable dans le cas ou elles interviennent sur le même volume physique. L’une ou l’autre des tâches était perturbée par des pertes d’images, ce qui peut s’avérer critique lors d'acquisition de flux en direct.

GB Labs sait gérer les priorités par type de flux afin de permettre aux monteurs de travailler sans être perturbés par les flux capturés par d’autres régies et vice-versa. Ainsi, les données sont capturées sur le même serveur et montées dans la foulée là où souvent elles doivent être déplacées du disque d’ingest vers le disque de travail.

BANDWIDTH CONTROL

Dans la même logique, il peut être utile en particulier sur les grosses installations de gérer les priorités de bande passante pour certains postes ou utilisateurs. Les solutions GB Labs permettent de le faire, et ce de deux manières :

La première (présente sur tout leurs systèmes) permet de décider de mettre un quota de bande passante par machine ou groupe de machines (plage IP). On sait par exemple que telle station de montage même si connectée en 10 Gb n’aura besoin au maximum que de 250 Mo/s en lecture/écriture, mais que l’opérateur a la fâcheuse habitude de lancer de grosses copies éventuellement pénalisantes et inutiles depuis son poste. On pourra de cette manière choisir de le brider pour être sûr que les autres ne soient pas gênés.

DYNAMIC BANDWIDTH CONTROL

Tiger Technology et les anciens systèmes ?

Comme beaucoup de nos clients le savent, Atreid et Tiger Technology ont été et sont toujours partenaires depuis de nombreuses années. Cependant, des changements de politique tarifaire et l’orientation très axée Cloud au détriment des autres développements nous ont incité à rechercher d’autres systèmes à même de répondre aux besoins de nos clients.

La réflection et les phases de test ont pris presque deux ans. Nous avons étudié les différentes solutions du marché tout en retenant les leçons passées.

Une des plus grandes critiques des systèmes Tiger Technology et autres fabricants concerne l'installation de logiciel client sur tous les postes utilisateurs.

C’est pourquoi nous nous sommes très vite orientés vers des fabricants qui proposaient des protocoles de connection génériques. C’est là que nous nous sommes rendus compte que tout le monde ne proposait pas du tout la même chose, même en se reposant sur les mêmes protocoles.

Beaucoup de fabricants proposent en effet des solutions qui pourraient être adaptées à la post-production mais qui se retrouvent vite mises en défaut du fait de l’absence de cache bien géré ou d’une optimisation sérieuse du matériel et adaptée aux flux de post-production.

GB Labs nous a intéressé car leur approche est axée sur vos métiers et les usages courants et pas sur des performances brutes sur un ou deux flux. Le fait qu’ils aient longtemps installé eux même leur produits et leur passé d’ancien intégrateur nous confère une expérience commune et une bonne connaissance des problématiques de nos clients.

De plus, une fois mis en production chez des clients tests, ceux-ci initialement bloqués sur des spécificités matérielles (nombre de disques, contrôleur RAID) se sont vite rendu compte que la solution faisait plus que son Job face à n’importe quelle solution équivalente déployée dans les mêmes conditions.

Il est évident qu’un client qui a investi des sommes conséquentes dans une solution Fiber Channel par exemple récemment ne voudra pas (et n’aura pas besoin de tout remplacer).

Un point clef dans l’utilisation de vos stockages et la catégorisation et le cycle de vie de vos données. Il peut être tentant de tout garder en haute disponibilité sur votre stockage le plus rapide, on se rendra vite compte qu’un pourcentage élevé de ces données n’est pas ou peu utilisé et n’a pas besoin de haute disponibilité.

Notre approche pour ces usages sera de réutiliser l’infrastructure et les stockages encore performants et de les connecter à un produit appelé EchoBridge. Celui-ci au travers d’interfaces SAS ou Fiber Channel permettra de transformer ce stockage en Nearline accessible par le réseau. Selon les scénarios, nous envisagerons sans doute de lui adjoindre une unité de stockage intégralement SSD qui servira de cache quotidien pour les données en production. Les allées et venues entre le cache et le Nearline se feront automatiquement mais peuvent être aussi déclenchées manuellement si besoin. Dans le cas d’un utilisateur Tiger Box, celui ci sera utilisé comme Nearline via un partage SMB pour ne plus avoir à utiliser le support Tiger et le client associé.

Dans certains cas de figure, les solutions Tiger Technology peuvent néanmoins rester les plus adéquates et nous continuerons de les proposer si ça nous semble être le cas. Nous continuerons bien sûr à les maintenir et à vous apporter l’assistance nécessaire tout au long de la durée de vie du produit.

© Atreid - Mai 2020

la satisfaction de nos clients

Notre mission proposer les solutions les plus innovantes et adaptées pour la gestion des médias, au cours des cycles de montage, étalonnage, VFX, mixage, stockage et archivage